И индексация сайта

Содержание:

- YCCY

- Как проверить индексацию страницы в «Яндексе»?

- Как проверить индексацию сайта в Яндексе

- Индексация сайта в поиске

- Найдите скрытый текст

- Проверка индексации страниц сайта в Google

- Проверка индексации онлайн с помощью сторонних сервисов

- Почему не индексируется сайт в Google

- Как эффективно проиндексировать сайт

- Почему проект не индексируется

- Проанализируйте оптимизацию

- Способы проверки индексации сайта

- Что необходимо сделать для начала индексации нового сайта

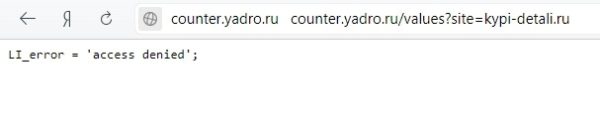

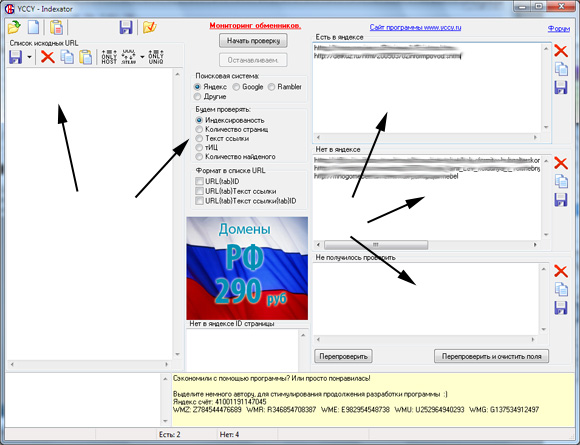

YCCY

Насколько я понимаю программка YCCY старожил на рынке seo, хотя до сих пор не потеряла свою актуальность. Вообще она содержит несколько модулей, которые выполняют разные задачи. Так, например, там есть некий WHOIS PAID, позволяющий массово проверять даты окончания доменов, NAME GENERATOR, генерирующий доменный имена и PageRankDC, который смотрит значение PR по разным дата центрам Google. Но самую большую ценность представляет модуль INDEXATOR. Он содержит следующие функции:

- Массовая проверка индексации страниц сайтов в Яндексе (через Mail.ru, Яндекс.XML) и в Google.

- Проверка количества проиндексированных страниц в Яндексе, Google, Rambler.

- Проверка Google PageRank, тИЦ, AlexaRank, бэклинков Yahoo.

- Пакетная проверка количества найденных страниц по запросу.

- Пакетная проверка обратных ссылок(текста ссылки) в Яндексе, Google.

При этом поддерживается экспорт ссылок PROPAGE, SAPE, XAP, прокси-сервера, что крайне полезно в работе. Вообще программа YCCY достойна похвалы. Работать с ней проще простого.

Слева добавляете нужные ссылки, далее указываете настройки проверки (в моем случае индексация страниц в ПС), а потом запускаем процесс. В результате справа в первом блоке появятся проиндексированные ссылки, потом не проиндексированные и те, которые не смогли определиться (для них можно запустить повторную проверку).

Если говорить о результатах, то на 90-95% информация программы соответствует действительности, а это, поверьте, среди других онлайн сервисов просто блестящий показатель. Что касается отзывов, то в большинстве случаев читал только положительные. Причем люди сравнивали с некоторыми другими похожими программами (хоть и давно это было). Оптимизаторы говорили, что YCCY работает быстрее остальных, хотя при проверке большого числа страниц пишут, что Яша может забанить IP (что, в принципе, для всех программ характерно — в YCCY можно и нужно использовать прокси).

Как проверить индексацию страницы в «Яндексе»?

Начнём с «Яндекса», поскольку русскоязычный поисковик должен быть в приоритете в большинстве случаев – за исключением, скажем, тех, когда вы продвигаете услуги для иностранцев. Есть 2 простых способа анализа:

- Через «Яндекс.Вебмастер».

- Через спецоператор поисковой системы.

Первый, безусловно, проще – если твой сайт уже добавлен в «Яндекс.Вебмастер». Если нет, рекомендую не медлить с этим.

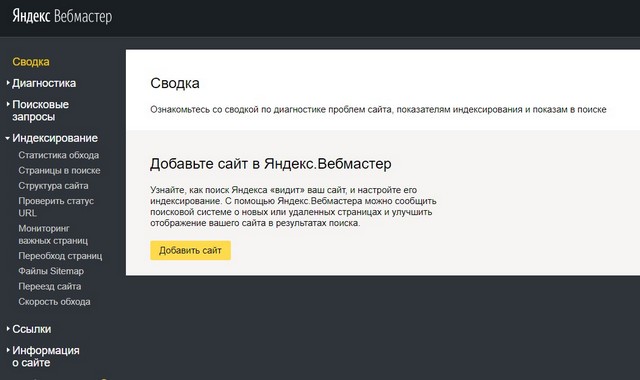

В самом «Вебмастере» нужно проследовать по пути «Индексирование» – «Проверить статус URL».

На экране появится такое поле:

Вбиваем в него URL и кликаем на «Проверить».

Результат появляется на экране в течение пары секунд. Если пишут, как на скрине выше – мол, обходится и находится в поиске – значит, уже проиндексировано. Справа две полезные кнопки: «Подробнее» и «Отслеживать». С помощью кнопки «Подробнее» можно посмотреть, когда поисковик в последний раз заходил на страницу.

Назначение кнопки «Отслеживать» ясно. С ее помощью можно контролировать состояние важных страниц – например, коммерческой, с наивысшим процентом лидогенерации. Если отслеживаемая страничка вдруг выпадет из индекса, на почту придёт оповещение об этом.

Второй способ – через оператор поисковой системы. Им можешь воспользоваться, если сайт в «Вебмастер» еще не добавил. В случае с «Яндекс» это оператор URL. Просто вбей в поисковую строку запрос в формате URL:{адрес сайта}. Например:

url:https://kovalev-copyright.ru/

Если поисковик ответит, что «нашёлся 1 результат» – бинго! Значит, страница в индексе.

Если же ответом будет «По вашему запросу ничего не нашлось», это значит, что робот еще здесь не ходил.

Как проверить индексацию сайта в Яндексе

Чтобы проверить процесс индексирования сайта в системе Яндекс нужно что бы ваш сайт был зарегистрирован в Яндекс.Вебмастере.

Ранее я уже показывала, как зарегистрировать сайт в поисковых системах.

Ознакомиться с ними вы можете по этим ссылкам:

Как добавить сайт в поиск GoogleКак в Яндекс.Вебмастер добавить сайт

- 1.Заходим в свою учетную запись в Яндекс.Вебмастера и нажимаем на кнопку «Войти»

- 2.В открывшейся форме вводим свои логин и пароль, после чего, опять нажимаем «Войти».

- 3.Сразу же, на стартовой странице вы увидите график и данные о количестве загруженных страниц в поисковую систему роботом, количество проиндексированных страниц и количество исключенных страницы из индекса.

- 4.Кликнув по графику или перейдя в пункт левого бокового меню «Индексирование» => «Статистика» вы можете просмотреть более подробную статистику. Вы можете подробно проверить по датам процесс добавления страниц в поисковую систему.

- 5.Кликнув по раскрывающемуся меню под названием сайта, вы можете отфильтровать показания графика:

- 6.Пролистав страницу, можно ознакомиться с полным перечнем страниц, которые уже находятся выдаче и датой их переобхода роботом

Если вы добавили на сайт новую страницу или запись, либо вы внесли какие-то изменения в уже существующие страницы, и вам нужно провести повторную индексацию, то вы можете сообщить об этом роботу Яндекс, воспользовавшись инструментом «Переобход страниц» в разделе бокового меню «Инструменты».

Вам нужно вставить адрес страницы, для которой нужно провести принудительное индексирование и нажить на кнопку «Отправить».

Ниже расположен перечень, в котором содержаться страницы, ранее отправленные на повторное индексирование.

В графе «Статус» отображается ход индексирования, а в графе «Отправлен» отображается время посещения страницы роботом.

Индексация сайта в поиске

Теперь, когда мы рассказали, что такое индексация, почему она так важна и как её проверить, приступим к практике.

Как ускорить индексацию?

Мы писали выше, что управлять индексацией, что бы кто не говорил, вы не можете. Но повлиять на процесс или даже ускорить возможно.

Советы по ускорению индексации

- Обязательно добавьте сайт во все сервисы Яндекса и Google, особенно в Яндекс Вебмастер и Google Search Console.

- Создайте sitemap.xml, поместите карту в корень сайта и постоянно обновляйте.

- Следите за robots.txt и исключайте ненужные страницы (об этом ниже).

- Выберите надёжный и быстрый хостинг, чтобы робот мог беспрепятственно индексировать содержимое сайта.

- Используйте инструменты Яндекс Вебмастера (Индексирование → Переобход страниц) и Google Search Console (Проверка URL → Запросить индексирование). Способ идеально подходит для работы с отдельными страницами.

- Если ваша CMS любит создавать дубли (например, Битрикс), то используйте атрибут rel=canonical.

- Автоматизируйте создание новых ссылок со старых страниц. Как вариант, можно сделать блок на главной с новыми товарами или статьями.

- Ведите соцсети и анонсируйте новые товары, услуги, страницы. Замечено, что ссылки с соцсетей могут ускорить процесс.

- Создавайте качественный контент на каждой странице. Под качественным контентом мы понимаем актуальную, релевантную и уникальную информацию для пользователей.

- Работайте над структурой сайта и делайте её удобной и понятной пользователю. Помните о правиле 3 кликов: это оптимальное количество действий для пользователя.

- Проверяйте периодически сайт на вирусы и санкции поисковых систем. В Яндекс Вебмастере раздел Диагностика → Безопасность и нарушения, в Google Search Console — раздел Проблемы безопасности и меры, принятые вручную.

- Улучшайте свой ссылочный профиль и пишите анонсы на других сайтах (в рамках правил поисковых систем).

- Используйте родные браузеры (Chrome, Яндекс Браузер) и заходите на новые страницы с них.

Как запретить индексацию?

Выше мы рассмотрели основные способы, как ускорить индексацию, и рассказали, что такое краулинговый бюджет и почему он ограничен для каждого сайта. Поэтому чтобы его не тратить зря, советуем закрывать от индексации служебные и технические страницы, кабинеты пользователей и конфиденциальную информацию, а также страницы в разработке и дубли.

3 основных способа запретить индексацию:

- Директива Disallow в файле robots. Мы писали, что такой запрет может не сработать в отдельных случаях. Тем не менее это основной способ запрета индексации.

- В коде страницы указать метатег robots с директивой noindex (для текста) и/или nofollow (для ссылок). Хорошо подходит для запрета индексации отдельных страниц.

- Настроить HTTP-заголовок X-Robots-Tag с директивой noindex и/или nofollow. Лучше всего подходит для закрытия индексации не HTML-файлов (PDF, изображения, видео и другие).

Используйте все наши советы по улучшению индексации на полную мощь.

Максимальное внимание уделите улучшению структуры и навигации и обновлению карты сайта.

Структура сайта должна быть проста и понятна, охватывать весь спектр ключевых запросов, а каждая страница сайта в идеале должна быть доступна в 3–4 клика

Для этого используйте дополнительные блоки на главной странице и в разделах.

Хорошо работает облако тегов: с помощью него часто получается продвигать категории, улучшать навигацию и полно охватывать семантику.

Для многостраничных сайтов действительно важно постоянно обновлять sitemap.xml

Зачастую в таких случаях карту делят на несколько частей, чтобы охватить весь список страниц.

Настройте маски (автоматические шаблоны) метатегов для новых страниц в категориях и каталогах.

Скорее всего, вам не обойтись без команды профессионалов, которые смогут обеспечить техподдержку, производство контента и SEO-продвижение.

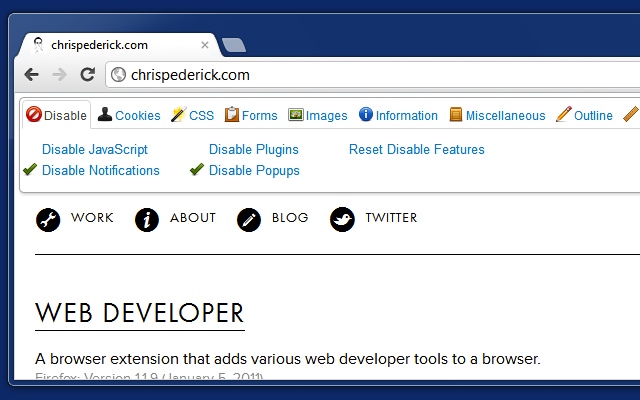

Найдите скрытый текст

Некоторые оптимизаторы используют приемы «черного SEO», чтобы повлиять на ранжирование. Добавляют на страницу ключевые слова с помощью скрытого текста, который не могут прочесть пользователи, но воспринимают и учитывают поисковики. Обычно скрывают текст так: делают его нечитаемого кегеля или одинакового цвета с фоном, помещают за пределы экрана с помощью CSS или другими способами.

Скрыть текст с целью повлиять на рейтинг — это нарушение правил поисковиков, за него последуют санкции.

Яндекс наказывает исключением страниц из поиска, Google тоже применяет ручные меры. Если вы использовали такой метод, но попали под санкции, удалите скрытый текст или сделайте его видимым и запустите проверку через систему для Вебмастеров.

Скрытый текст применяют не только для черных методов продвижения, но и для того, чтобы сделать ресурс удобнее и понятнее пользователям и поисковикам, которые могут видеть сайт по-разному из-за реализованных стилей CSS или элементов JavaScript.

Веб-мастеры рекомендуют добавить скрытое текстовое описание к элементам JavaScript и изображениям. Дублируйте содержание JavaScript в теге noscript, а для изображений используйте естественное описание с ключами в теге «alt». Описания помогут ориентироваться на сайте пользователям, которые не могут загрузить изображения и плагины, и подскажут поисковикам, по каким ключам ранжировать изображения. От Flash лучше отказаться — эти элементы создают брешь в безопасности сайта и могут не поддерживаться у пользователей.

Проверьте, как видят страницу пользователи, которые смотрят сайт в режиме с отключенными плагинами, и как ее воспринимают поисковики. Найти скрытый текст поможет отключение элементов JavaScript, стилей CSS и изображений.

Отключить CSS и JS можно с помощью браузерного расширения Web Developer, если вы пользуетесь Google Chrome.

Расширение Web Developer для работы с CSS и JS

Расширение Web Developer для работы с CSS и JS

Отключите элементы, перезагрузите страницу и сравните содержимое: проверьте, не виден ли текст, который должен быть скрытым, и наоборот. Скрытые элементы CSS веб-мастера обычно рекомендуют удалить или отредактировать, чтобы сайт отображался корректно на всех устройствах и браузерах.

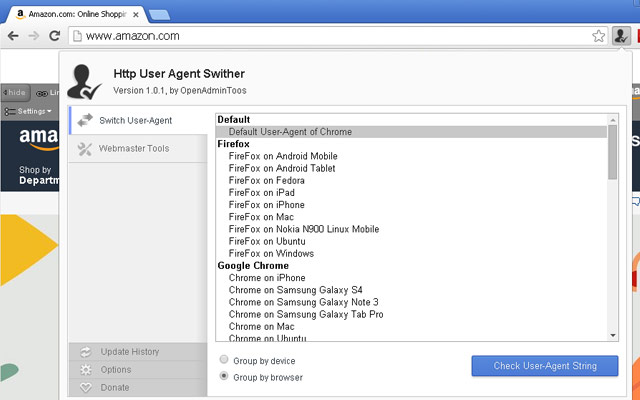

Посмотреть, как выглядит страница на разных устройствах, можно с помощью расширения «HTTP User Agent Switcher» для Google Chrome. Расширение также покажет, как мобильную и десктопную страницу видит Googlebot.

Настройка Agent Switcher

Настройка Agent Switcher

Джон Мюллер утверждает, что краулер Google обрабатывает Javascript только во время второй волны рендеринга и индексирования, поэтому не нужно дублировать сигналы в HTML и Javascript, если вы изменяете теги через Javascript или хотите отключить индексирование страницы.

Проверьте, как боты воспринимают страницу и какой видят текст. Бесплатно посмотреть на сайт глазами поискового робота поможет инструмент:

Пример анализа инструментом

Пример анализа инструментом

Кроме того, он считает количество внутренних и внешних ссылок, и определяет, какие из них индексируются поисковиками.

Проверка индексации страниц сайта в Google

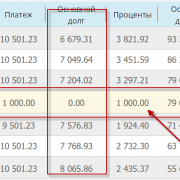

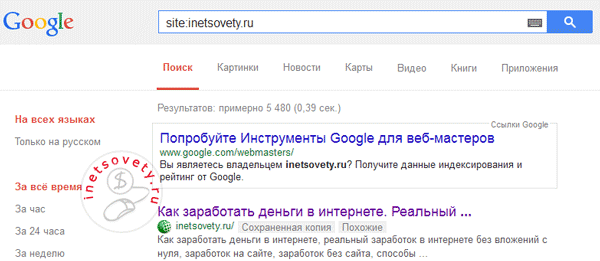

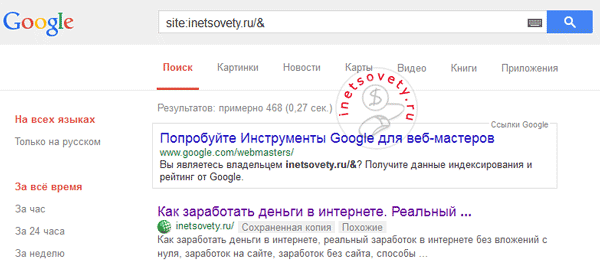

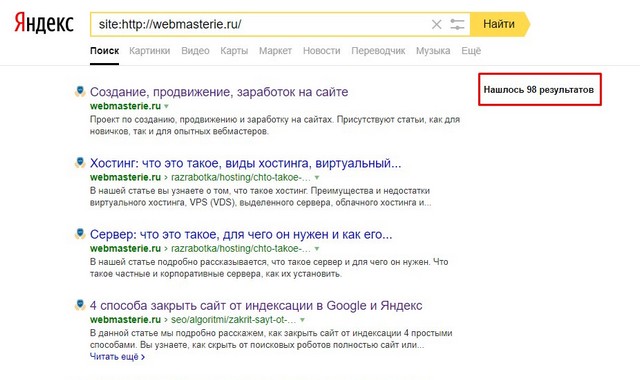

В Google работает только один оператор site, показывающий число проиндексированных страниц. Отличие Гугла от Яндекса заключается в том, что у Google есть основной и дополнительный индекс. Что каждый из них представляет читайте ниже.

Дополнительный индекс Google. Сеошники дали ему название «сопли», так как в нем находятся все страницы и документы, которые роботу Google удалось найти на Вашем сайте. Сюда можно отнести страницы сайта, которые запрещены для показа в основной выдаче: это могут быть дублирующие страницы сайта, которые создаются из-за новых комментариев, страницы постраничной навигации.

Основной индекс Google. В нем находятся все проиндексированные страницы Вашего сайта, которые показываются пользователям интернета в результатах выдачи по искомым ключевым фразам. Чтобы определить какие страницы сайта попали в основной индекс, добавьте к оператору символ &, как показано на картинке ниже. Символ & находится на клавиатуре на кнопке с цифрой 7.

На первой картинке показано 5 480 результатов, а на второй — 468. По своей неопытности, я сразу после создания своего блога не закрыла от индексации ненужные разделы в файле robots.txt. В то время, когда я создавала блог информации было не много на тему создания сайтов, приходилось все делать «методом проб и ошибок». Это сейчас уже и готовые примеры файла robots.txt есть в сети и рекомендации по его настройке. Поэтому мусорных страниц, которые не несут никакой информации и пользы, Гугл успел насобирать до 5 000 штук.

Полную картину того, какая индексация сайта в поисковых системах, именно у Вашего сайта покажет панель инструментов для веб-мастеров Яндекса и Гугла. Если Вы еще не подключили сайта ни к одной из этих панелей, скорее сделайте это. Помогут Вам в этом эти статьи-инструкции:

- Инструменты Google Tools https://inetsovety.ru/google-search-console/

- Яндекс Вебмастер https://inetsovety.ru/yandex-webmaster/

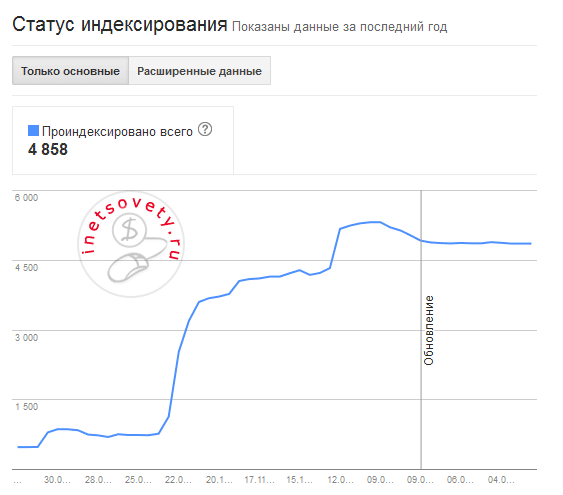

В инструментах Гугла в пункте Индекс Google, Вам будет показан график с изменением количества страниц по датам. Главное, чтобы он был ровным, а не такой, как у меня :):

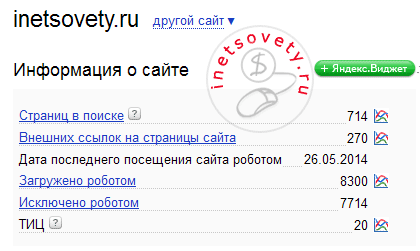

На главной странице Яндекс Вебмастера, Вы увидите численное значение проиндексированных страниц, а кликнув по значку графика напротив строки «Страниц в поиске», сможете посмотреть график за последние 3 месяца.  А самый простой способ проверить индексацию сайта и посмотреть какое количество страниц в индексе Яндекса и Гугла — воспользоваться одним из следующих бесплатных сервисов:

А самый простой способ проверить индексацию сайта и посмотреть какое количество страниц в индексе Яндекса и Гугла — воспользоваться одним из следующих бесплатных сервисов:

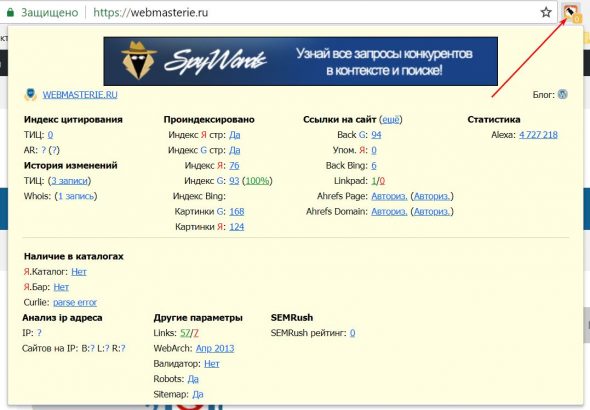

- плагин RDS bar. Устанавливается, как дополнение, для любого браузера. И позволяет в несколько кликов посмотреть информацию по основным параметрам для любого сайта.

- инструменты для вебмастера . В этом сервисе мне больше всего нравится графическое представление статистики по изменению показателей сайта и по индексации сайта в Яндексе и Гугле

Проверка индексации онлайн с помощью сторонних сервисов

Ладно, разобрались с тем, как проверить URL единственной страницы через поисковую строку или панели «Вебмастера» и «Серч Консоль». Но что делать, если таких URL куча и требуется пакетное решение? Ответ – прибегнуть к одному из сторонних сервисов. Вот список тех, которыми я лично пользовался:

- Raskruty.ru (лимит – 10 url).

- «Проверка индексации, возраста и даты кэша в Яндексе» от Pixel Plus (лимит – 50 url).

- Сервис от BE1 (лимит – 50 url).

- Серпхант (лимит – 100 url).

Когда я был молодым и глупым, юзал примитивный Raskruty.ru. Тогда он ещё стабильно «чекал» индексацию в Google. Но сейчас у него и двух следующих сервисов есть катастрофический общий недостаток: они проверяют только в «Яндекс».

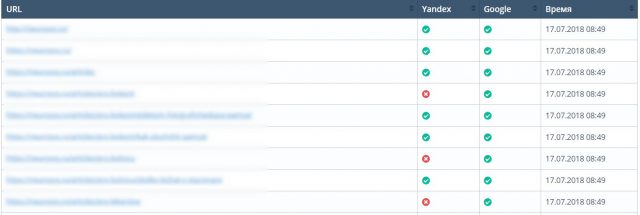

С «Серпхант» я познакомился позже и, честно говоря, при знакомстве испытал дикий восторг. Скажу сразу, что ребята мне не платят, и заметьте: я здесь нигде не воткнул их партнёрскую ссылку. Просто они делают действительно эффективные SEO-инструменты. Это касается и инструмента анализа индексирования – считаю его лучшим по ряду причин:

- Проверяет и в Google, и в «Яндекс».

- Лимит в 100 УРЛов, когда у аналогов – максимум 50.

- Имеет привлекательный, не допотопный (как у Raskruty) интерфейс.

Вот так выглядит итоговый отчет на «Серпхант»:

С помощью «Серпхант» можно также совершенно бесплатно проверить позиции сайта или частотность запросов. Категорически рекомендую к использованию!

Почему не индексируется сайт в Google

Причины могут быть разными. Рассмотрим наиболее часто встречающиеся:

- Новый сайт. В этом случае нужно только терпение и время. Не все страницы нового ресурса сразу попадают в индекс «Гугла». Иногда процесс индексации может растянуться на несколько месяцев.

- Отсутствие карты сайта (файл Sitemap). Профессионально составленная карта сайта помогает поисковым ботам быстрее сканировать страницы сайта. Ссылка на файл «Сайтмеп» должна быть добавлена в панель веб-мастеров.

- Ошибки на страницах сайта. В панели для веб-мастеров «Гугл» постоянно уведомляет собственников интернет-ресурсов о появляющихся ошибках. Если есть проблема с индексацией сайта в Google, посмотрите, какие ошибки находит поисковый бот, и исправьте их.

- Ошибка с метатегом robots. Она может появиться из-за неправильного изменения настроек CMS или хостинга. В коде интернет-страниц в этом случае появится строка: <meta name=»robots» content=»noindex, follow» />

- Ошибка с robots.txt. Такая ошибка является следствием рекомендаций закрывать в robots.txt все ненужное. Но всего лишь один лишний символ способен закрыть страницу или даже сайт от индексации. При неправильном закрывании от поисковой системы части сайта можно случайно прихватить и другие разделы ресурса. Если ресурс закрыт для индексации, в файле robots.txt можно обнаружить тег: User-agent: * Disallow: /

Проблемы с индексаций сайта в Google могут возникнуть также под влиянием следующих факторов:

- дубли страниц;

- недостаточный процент уникальности контента;

- затрудненный доступ к страницам и длительное время их загрузки.

Часто проблема заключается не в самой индексации, а в методах оптимизации сайта. Чтобы ваш ресурс быстро индексировался в Google, нужно лучше конкурентов удовлетворять запросы пользователей. При таком подходе все, что описано в этом материале, понадобится только для фиксации качественного результата.

Как эффективно проиндексировать сайт

Чтобы сайт как можно быстрее начали индексировать поисковые системы, его надо добавить в базу поисковиков через инструменты для вебмастеров.

Добавьте сайт в Яндекс.Вебмастер

Простой ответ на вопрос «Как проиндексировать сайт в Яндексе?» — добавить его в Вебмастер.

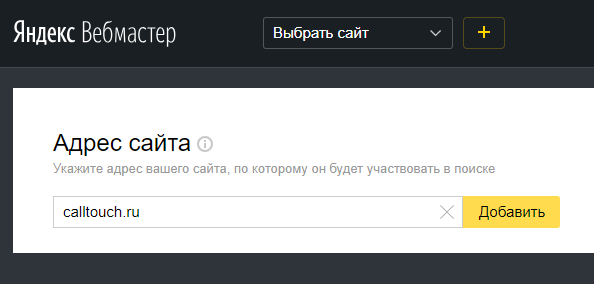

Для начала, заведите личный кабинет в сервисе и добавьте сайт в главном меню по адресу https://webmaster.yandex.ru/sites/add/.

На следующем шаге скопируйте код подтверждения и добавьте его в исходный код главной страницы сайта в раздел <head>.

Для повышения точности данных привяжите Яндекс.Метрику к сайту в пункте Настройки -> Привязка к Яндекс.Метрике. Информацию из Метрики робот будет использовать при обходах.

Чтобы проверить, проиндексированы ли какие-то страницы на текущий момент, перейдите в меню Индексирование -> Проверить статус URL.

В том же меню есть информация о том, когда и с каким результатом робот обходил страницы, какие из них есть в поиске, а также функция добавления Sitemap, запуска переобхода и настройки скорости обхода.

Добавьте сайт в Google Search Console

Перейдите на https://search.google.com/search-console/welcome и войдите в учётную запись. Добавьте сайт в систему.

Как и в Яндекс.Вебмастере, инструмент предлагает множество отчётов о состоянии индексации сайта. Вы может увидеть, какие страницы проиндексированы и добавлены в поиск, внутренние и внешние ссылки и многое другое.

При этом, если Яндекс автоматически обнаруживает файлы Sitemap и имеет гибкие настройки переиндексации, то у Google Search Console с этим возникнуть проблемы. Иногда он не может найти файлы Sitemap и их обязательно нужно загрузить вручную. Настройки повторного обхода страниц после обновлений не так удобны — сперва необходимо проверить конкретный URL, а лишь затем появится кнопка Запросить индексирование.

Добавление сайта в прочие поисковые системы

В российском сегменте интернета доля поисковых систем помимо Яндекса и Google стремится к нулю. Тем не менее, не следует ими пренебрегать, если сайт является важным имиджевым элементом крупного проекта или организации.

Рамблер

Рамблер основан на тех же данных индексации, которые собирает Яндекс — в этом случае нет необходимости в дополнительных настройках.

Mail.ru

Mail.ru, в свою очередь, пока располагает своим кабинетом для вебмастеров https://webmaster.mail.ru/. В нём предусмотрен минимальный набор управления и отслеживания индексации в системе.

Yahoo.com и Bing

Как ни странно, в определённый момент Bing, принадлежащий Microsoft, поглотил поисковый движок Yahoo, объединив помимо прочего их сервисы для вебмастеров под вывеской https://www.bing.com/toolbox/webmaster/.

Почему проект не индексируется

Мы подробно рассмотрели, что такое индексация сайта, для чего она нужна, какую играет роль. Мы узнали, как проводится проверка индексации сайта в Яндексе и Google. Теперь нужно понять, почему страницы ресурса могут не попасть в базу поисковых систем. Тут возможно несколько вариантов развития событий.

Во-первых, ошибка 404. Распространенная проблема, когда страница недоступна. Следовательно, поисковый робот не может ее найти, проанализировать и добавить в базу. И проверка индексации страниц сайта не даст желаемый результат. Это может случиться из-за отсутствия самой страницы, неправильного адреса или блокировки скриптом. Необходимо проверить весь проект на предмет ошибок, проанализировать работу скриптов. Многие из них отправляют сообщение о результате проверки, что поможет выявить проблему и устранить ее. После исправления ошибок стоит повторно проверить индексацию сайта.

Во-вторых, спам или переоптимизация. Здесь подразумевается манипуляция пользователями и поисковыми системами с целью привлечь трафик на ресурс. Здесь могут быть использованы различные подходы, например, добавление большого количества ключевых слов в заголовок и текст страницы, маскирование ключевых слов при помощи цвета фона или мелкого шрифта и так далее. Визуально страница может выглядеть нормально (для пользователя), но в глазах поискового робота она будет избыточно нагружена ключевыми словами. Результат — неудачная проверка сайта в поисковых системах.

Использовать подобные сомнительные способы продвижения не стоит, поскольку сегодня поисковики могут успешно определять спам и переоптимизацию, что наказывается фильтрами и баном всего проекта. Подобные подходы могут привести и к снижению позиций в поисковой выдаче, что негативно скажется на общем состоянии сайта. Мгновенное перенаправление на другую страницу (длительность перенаправления равна 0 секунд) тоже может закончиться исключением из списка выдачи.

Помните, что поисковики служат для пользователей. Они предоставляют им сайты с информацией, которая максимально релевантна их запросам, то есть соответствует тому, что они ищут. Задача оптимизатора — создать такой контент, который легко ищется поисковиком и предоставляется пользователю. И своевременная проверка индексации сайта в Гугле и Яндексе имеет здесь весомое значение.

В-третьих, ошибки в датах. Поисковики умеют сортировать загружаемые данные по датам, однако это не всегда происходит верно. По этим причинам нужно не только правильно отображать данные о времени публикации в HTML документе, но и поработать с настройками вебсервера. Будет хорошим тоном настроить систему так, чтобы при передаче запросов указывались временные данные, что позволит исключить возможные неприятности. В этом случае проверка индексации сайтов покажет положительный результат.

В-четвертых, проблемы с кодировок. Очень частая и крайне неприятная ситуация. Если в HTML документе неправильно указана кодировка текстов (или ее там вовсе нет), то на выходе поисковый робот может загрузить не полноценный текстовый материал, а набор символов. Особенно это актуально при работе с документами не на английском языке (русский, украинский и пр.). Соответствующие правки можно внести в мета-тег «Content-type». Это поможет обезопасить себя и сделать посещение сайта комфортным для пользователей.

Если проект содержит одинаковые страницы, но с разным языковым наполнением, то тут стоит осуществлять передачу кодировок в разных robots.txt на разных портах (серверах). Если передача проходит по директориям, то достаточно одного robots с соответствующими записями. После внесения изменений не забудьте проверить индексацию сайта в Google и Yandex.

В-пятых, загрузка одного веб-сайта с разных серверов. Эта проблема актуальна при наличии зеркал или mirror. Под ними понимают разные доменные адреса, ведущие на один и тот же сайт. В результате может случиться так, что поисковый бот проиндексирует один из вариантов, а другой документ исключит (а ведь это может быть не зеркало, а основной ресурс). Здесь поможет внесение записей в файл robots.txt.

Стоит поговорить и о том, сколько индексируется сайт в Яндексе или в Google. Длительность процедуры нигде не установлена и может составлять как один день, так и несколько недель. На это влияет ряд факторов:

- возраст сайта;

- состояние внутренней оптимизации (перелинковка);

- наличие ошибок на сайте;

- скорость загрузки страниц;

- количество и качество контента.

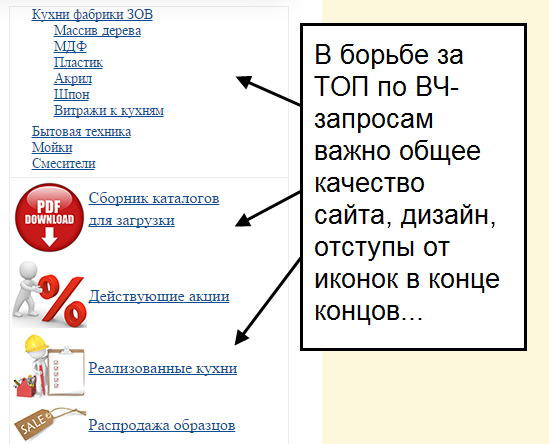

Проанализируйте оптимизацию

Кроме пунктов из предыдущих разделов, в рамках быстрого самостоятельного SEO-аудита нужно сосредоточиться на самых важных элементах оптимизации, которые могут повлиять на отношение поисковиков и органический трафик.

Проверить оптимизацию страницы:

- Title .

Релевантный заголовок с ключом, отображается в сниппете выдачи и на вкладке, не дублируется. Рекомендуемый размер — 70-80 знаков. - H1 заголовок.

Релевантный заголовок страницы с ключом, должен быть в единственном варианте. - H2-H3 заголовки.

Содержат релевантные ключи, раскрывают тему. - Descriptions.

Описание, используется в сниппете, содержит ключи и поясняет содержимое. - Редиректы .

Не используйте тег «meta refresh», а также не рекомендуют использовать ссылки с 301 редиректом, поскольку Google может не проиндексировать конечный URL. - Сканирование страниц и индексация.

Важные страницы открыты для индексации в

robots.txt и указаны в карте сайта. - Внутренняя перелинковка.

Важные страницы имею минимальный уровень вложенности, перелинкованы с главной и другими авторитетными страницами сайта. - Высокая скорость загрузки.

Сервер быстро

обрабатывает запрос, все JS-элементы и стили загружаются в течение 5 секунд, пользователь видит загрузку уже спустя пару секунд после перехода. - Корректная кодировка.

Кодировка, которую отправляет сервер, совпадает с кодировкой сайта. Информация о ней есть в строке «Content-Type: text/html; charset=utf-8»

ответа сервера, где «utf-8» — указание кодировки. В исходном коде страницы должна быть такая же: . Укажите эту строку в шаблоне сайте в теге «head».

Вы можете проверить эти пункты вручную, но для экономии времени можно использовать автоматический инструмент. Сервис «Анализ сайта» от PR-CY умеет

анализировать внутренние страницы ресурса по самым важным параметрам.

Раздел с анализом внутренних страниц сайта находится в левом меню под Расширенным анализом. В настройках есть режимы анализа с задержкой между запросами, с учетом robots.txt и без него.

Анализ всех страниц

Сервис оценивает коды ответов сервера, мета-теги, оптимизацию контента и технические характеристики, дает пояснения и советы к каждому пункту.

Фрагмент анализа внутренних страниц

Сервис проанализирует страницы пакетом в указанном количестве и отдельно покажет статистику с выбранными фильтрами по каждой.

Фрагмент анализа по каждой странице

Вы можете установить нужные фильтры из обширного списка и найти те страницы, в которых есть, к примеру, неуникальный Title или Description с конкретным ключом.

Фрагмент анализа с фильтром

Результаты можно скачать в табличке формата XLS, в ней будет сборная информация по каждой странице.

Фрагмент анализа в таблице XLS

После всех этапов быстрого аудита у вас будет список главных ошибок, которые влияют на органический трафик и сканирование сайта поисковиками.

Анализ множества страниц позволит выявить массу реальных проблем, которые мешают получать больше трафика и занимать более высокие места в поисковых системах. Причем выявить главные проблемы можно за несколько минут, их исправление уже намного улучшит состояние ресурса. А с помощью автоматических инструментов это будет еще проще и быстрее выполнить.

Способы проверки индексации сайта

Предлагаем вашему вниманию 4 самых распространенных и простых способа, позволяющие проверить, какие страницы есть в индексе, а какие – нет.

1. Через панель вебмастера

Этим методом владельцы веб-ресурсов проверяют их наличие в поиске чаще всего.

Яндекс

- Авторизуйтесь в Яндекс.Вебмастер.

- Перейдите в меню «Индексирование сайта».

- Под ним найдите строку «Страницы в поиске».

Можно пойти и по другому пути:

- Выберите «Индексирование сайта».

- Дальше перейдите в «История».

- Затем кликните на вкладку «Страницы в поиске».

И первым, и вторым способом вы сможете изучить динамику роста или спада числа страниц в поисковой системе.

- Зайдите в панель управления сервиса .

- Кликните на вкладку Search Console.

- Перейдите в «Индекс Google».

- Нажмите на опцию «Статус индексирования».

2. Через операторов поисковых систем

Они помогают уточнить результаты поиска. Так, применение оператора «site» позволяет увидеть приблизительное число страниц, которые уже находятся в индексе. Чтобы проверить этот параметр, в строке поиска Яндекс либо Google укажите: «site:адрес_вашего_сайта».

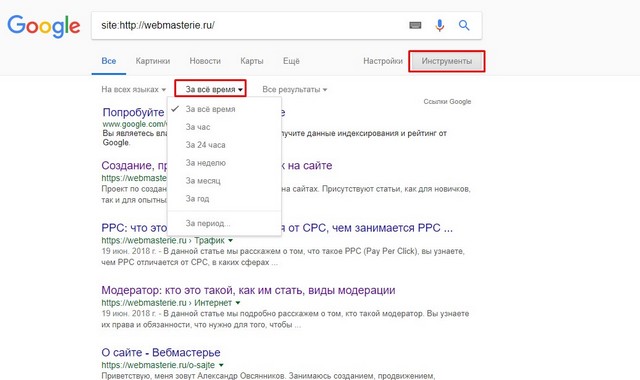

Важно! Если результаты в Google и Яндекс сильно разнятся между собой, то значит ваш сайт имеет какие-то проблемы со структурой сайта, мусорными страницы, индексацией или на него наложены санкции. Для поиска вы также можете использовать дополнительные инструменты, например, чтобы узнать, как изменялась индексация страниц за определенный период времени

Для этого под поисковой строкой нажмите на вкладку «Инструменты поиска» и выберите период, к примеру, «За 24 часа»

Для поиска вы также можете использовать дополнительные инструменты, например, чтобы узнать, как изменялась индексация страниц за определенный период времени. Для этого под поисковой строкой нажмите на вкладку «Инструменты поиска» и выберите период, к примеру, «За 24 часа».

3. Посредством плагинов и расширений

Используя специальные программы, проверка индексации веб-ресурса произойдет автоматически. Это можно сделать с помощью плагинов и расширений, еще известных как букмарклеты. Они представляют собой javascript-программы, которые сохраняются в браузере в виде стандартных закладок.

Преимущество плагинов и расширений в том, что вебмастеру нет необходимости каждый раз по новой заходить в поисковик и вводить там адреса сайтов, операторы и прочее. Скрипты произведут все в автоматическом режиме.

Самым популярным плагином, применяемым в этих целях, является RDS bar, который можно скачать в магазине приложений любого браузера.

Стоит отметить, что в Mozilla Firefox у плагина куда больше возможностей, чем в других браузерах. RDS bar предоставляет информацию относительно и всего веб-сайта, и его отдельных страниц

На заметку. Есть платные и бесплатные плагины. И самый большой минус бесплатных плагинов в том, что в них регулярно нужно вводить капчу.

Нельзя оставить без внимания и букмарклет «Проверка индексации». Чтобы включить программу, просто перетяните ссылку на панель браузера, а затем запустите свой портал и нажмите на закладку расширения. Так вы откроете новую вкладку с Яндекс или Google, где изучите нужную информацию касательно индексации определенных страниц.

4. С помощью специальных сервисов

Я в основном пользуюсь сторонними сервисами, потому что в них наглядно видно какие страницы в индексе, а какие там отсутствуют.

Бесплатный сервис

https://serphunt.ru/indexing/ — есть проверка, как по Яндекс, так и по Google. Бесплатно можно проверить до 50 страниц в сутки.

Платный сервис

Из платных мне больше всего нравится Topvisor — стоимость 0.024р. за проверку одной страницы.

Вы загружаете в сервис все страницы вашего сайта и он вам покажет, какие находятся в индексе поисковых систем, а какие нет.

Что необходимо сделать для начала индексации нового сайта

Чтобы поисковые роботы начали индексировать сайт, необходимо:

- Убедиться, что индексация открыта в robots.txt.

Это довольно распространенная ошибка: новый сайт не открывают для индексирования в robots.txt. Эта опция по умолчанию присутствует в большинстве систем управления ресурсами.

Закрытый от индексации сайт можно узнать по наличию звездочки:

Удаление этого значка делает сайт доступным для поисковых роботов.

Строка Disallow позволяет скрыть служебные разделы и прочие страницы, которые не требуют индексации.

- Добавить сайт в поисковые системы.

Проще всего «открыть» сайт для поисковых систем – это добавление через формы, а также в Google webmaster tools и «Яндекс.Вебмастере».

- Поставить ссылки с других сайтов.

На новый сайт должны вести индексируемые ссылки с других ресурсов. При наличии уже работающего собственного сайта переходы обеспечиваются с него, а при создании самого первого ссылки покупаются на специальных биржах. Оптимальным вариантом будет задействование авторитетных ресурсов, которые регулярно обновляются.

Отличной индексацией могут похвастаться блоги и сайты СМИ. Ссылочные биржи – простой и надежный способ разместить на этих ресурсах ссылки, ведущие на новый сайт, тем самым способствуя его изучению поисковиками и включению в индекс.

- Ссылки из социальных сетей.

Положительно отражаются на индексации сайта прямые ссылки из соцсетей. Twitter, Facebook, Google Plus, YouTube – эти и многие другие площадки помогут «познакомить» поисковые системы с вашим ресурсом.

Для ожидаемого результата необходимо следить, чтобы ссылки были обязательно прямыми. Редирект, который задействован в социальной сети «Вконтакте», не позволит добиться индексации сайта.

- Добавление сайта в социальные закладки.

Ситуация со ссылками из социальных закладок, которые еще несколько лет назад были отличным вариантом, сегодня слегка изменилась, но не для всех сервисов.

К социальным закладкам относятся такие сайты, как: bobrdobr.ru, memori.qip.ru, moemesto.ru, mister-wong.ru и сотни подобных им. Их несомненное достоинство в том, что благодаря им ваш ресурс будет быстро обнаружен поисковыми роботами.

Конечно, индексация сайта в поисковиках будет максимально успешной, если одновременно применять все способы.

Оптимизация сайта – очень важный этап раскрутки, но все меры по продвижению не принесут успеха, если ресурс не индексируется поисковыми системами, поэтому этот вопрос необходимо решить в первую очередь.

Вас также может заинтересовать: Сайт закрыт от индексации: это не повод для паники